Глава 4 Искусственный интеллект, его риски и непредсказуемость

Глава 4

Искусственный интеллект, его риски и непредсказуемость

Вместо того чтобы сразу приступить к дискуссии, возможен ли искусственный интеллект, я хочу выдвинуть крайнюю точку зрения, состоящую в том, что в определенном смысле ИИ уже существует.

Дело в том, что никакого естественного человеческого интеллекта не существует. Человеческий интеллект слагается из языка, понятий и приемов мышления, которые были придуманы людьми. Точка. Мы живем уже внутри искусственного интеллекта. Навыки человеческого мышления непрерывно и ускоренно развивались от появления зачатков речи через возникновение абстрактных понятий, математики, научного метода, а затем различных приемов обработки информации. Развитие это вначале происходило бессознательно и стихийно, а затем все более целенаправленно. Как заметил в свое время Г.В.Ф. Гегель: «Людям трудно поверить, что разум действителен; но на самом деле ничто не действительно, кроме разума; он есть абсолютная мощь».

Важно также избежать дискуссий о том, чем именно является ИИ, может ли машина обладать сознанием и так далее.

С точки зрения предмета нашего исследования важно только то, как искусственный интеллект может привести к глобальной катастрофе. И с этой точки зрения для нас важна только его способность решать задачи в реальном мире.

Далее надо отметить, что человеческий интеллект является свойством общества, а не отдельного человека.

Свойством отдельного человека является универсальная способность обучаться и решать новые задачи в незнакомой обстановке. Именно это свойство является базовым для любых форм коллективного интеллекта. Исследователи ИИ мечтают смоделировать именно эту универсальную способность решать любые задачи. Но сама по себе она не есть настоящий интеллект – а только его зачаток.

Большинство людей за свою жизнь не открывают ничего принципиально нового для науки, а каждый отдельный ученый делает только небольшой шаг, опирающийся на достижения предшественников и служащий опорой для следующего шага. Поэтому мы должны говорить не о развитии естественного интеллекта и создании искусственного, а о едином процессе создания интеллекта.

Этот процесс начался еще задолго до человека. Сама эволюция форм живой материи на Земле представляет собой развитие все более совершенных (и сложных) форм жизни. Выигрыш в решении задачи выживания и приспособления составлял «интеллектуальную задачу» эволюции. Вначале эволюция решала свои задачи путем простого перебора возможных вариантов, а затем это перебор стал оптимизироваться. Появилось половое размножение, мозг. И хотя то, как именно эволюция оптимизировала сама себя, остается спорным вопросом, сам факт ее самооптимизации налицо – и проявляется он во все более быстром эволюционном развитии.

Отсюда можно заключить, что самоусиление является естественным свойством интеллекта, потому что всегда ведет к выигрышу в решении задач. При этом «интеллект эволюции» был свойством всей биосферы, то есть имел распределенный характер. И по своим результатам этот интеллект был сверхчеловеческим, поскольку те задачи, которые он смог решить, – скажем, создание человеческого организма – человек сам пока решить не может. И из эволюции живых организмов произошла эволюция человеческого мозга, а затем – различных способов мышления, которым этот мозг стал пользоваться. В результате способность человека решать задачи превзошла способность эволюции создавать новые организмы – по скорости решения задач, но не по качественности продуктов. Однако затем стали развиваться способы усиления интеллекта с помощью машин, то есть появились компьютеры как вычислители, Интернет как среда обмена информацией и идеями, венчурный капитализм как способ организации деятельности, ведущей к наиболее быстрому отбору наиболее эффективных решений. При этом роль интеллекта отдельного человека стала снижаться. Если бы некая идея не пришла в голову кому-то одному, она бы пришла другому через год.

В результате мы видим естественный процесс перехода основного носителя интеллекта от генетического кода к нейронному мозгу а от них – к человеческим организациям (науке) и к компьютерам. При этом эффективность интеллекта как способа решения задач с каждым таким переходом увеличивается в разы, более того, интеллект становится все более заточенным на самосовершенствование, поскольку теперь он обладает рефлексией и понимает, что лучше потратить часть времени на обучение, улучшение вычислительной базы, наем более производительных сотрудников или разработку новых алгоритмов, чем на решение задачи в лоб.

Срок решения технической задачи

Итак, нет ничего удивительного в том, что рано или поздно интеллект окажется полностью на компьютерной базе, и при этом он будет в значительной мере нацелен на самосовершенствование и будет превосходить современный человеческий интеллект в разы – это продолжение того же эволюционного процесса, который создал самого человека.

Искусственный интеллект не является вечным двигателем: последнего не существует в природе, тогда как интеллект – как человеческий, так и эволюции – вполне успешно реализован. Поэтому попытки создать ИИ скорее подобны попыткам создать самолет в XIX веке, которые были настолько выразительно неудачны, что в Англии даже отказались рассматривать предложения о машинах тяжелее воздуха. Для создания самолета в XIX веке не хватало двух вещей – мощного двигателя и понимания аэродинамики работы крыла. И если второе было чисто «самолетной» проблемой, то появления достаточно мощного двигателя пришлось ждать. Сейчас устройство крыла планера нам кажется очевидным, и нам трудно понять, в чем же были трудности его создания. Точно так же когда-нибудь устройство ИИ станет очевидным. Но вторая половина вклада в создание ИИ должна прийти извне, и это – развитие мощных, а главное дешевых и доступных вычислительных машин, а также огромный объем упорядоченной оцифрованной информации в виде Интернета.

Другой критерий оценки воплотимости ИИ – это сопоставление реально существующих компьютеров с мозгом человека. Вычислительные способности мозга человека оцениваются в 1014 операций в секунду, данная цифра получается из умножения числа нейронов в мозге, принимаемого за 100 миллиардов, на максимальную частоту операций в мозге – 100 Гц, и еще один порядок накидывается про запас. Хотя эта оценка выглядит явно завышенной, так как в мозгу просто нет такого количества информации, чтобы обрабатывать его с такой производительностью. По зрительному каналу человек получает около 1 мегабайта информации в секунду, и большая часть мозга обрабатывает именно ее.

В любом случае современные суперкомпьютеры уже производят 1015 операций с плавающей запятой, то есть обладают сопоставимой с мозгом вычислительной силой.

Объем сознательной памяти человека, по оценкам, приводимым в статье Р. Кэрригена, составляет порядка 2,5 гигабайт, что, по нынешним меркам, ничтожно мало. Отсюда следует, что задача по созданию ИИ может оказаться гораздо проще, чем нам кажется. Количественный рост аппаратуры может привести к внезапному качественному скачку: например, новая кора головного мозга шимпанзе только в шесть раз меньше человеческой, однако шимпанзе не способно создать технический прогресс.

Несмотря на прошлые неудачи, в мире есть около десяти групп, которые открыто заявляют о намерении создать универсальный искусственный интеллект. Можно также предполагать, что есть некое число закрытых или военных проектов, а также частных лиц, которые работают над этой темой.

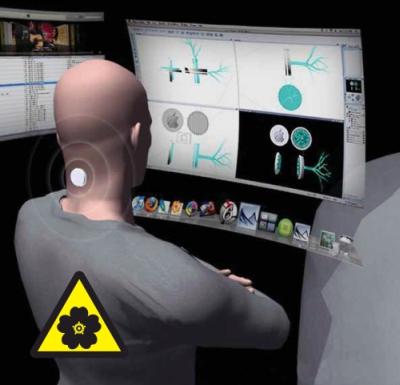

Приведу собранные мной данные о текущих исследованиях в области ИИ. Программа Blue Brain по моделированию мозга млекопитающих объявила осенью 2007 года об успешной имитации кортиковой колонки мозга мыши и запланировала создание полной модели мозга человека до 2020 года.[5] Хотя прямое моделирование мозга не является наилучшим путем к универсальному искусственному интеллекту, успехи в моделировании живого мозга могут служить в качестве легко читаемой временной шкалы прогресса в этой сложной науке.

Ник Бостром в своей статье «Сколько осталось до суперинтеллекта?»[6] показывает, что современное развитие технологий ведет к созданию искусственного интеллекта, превосходящего человеческий, в первой трети XXI века.

Крупнейшая в мире компьютерная компания Google несколько раз упоминала о планах создания искусственного интеллекта, и, безусловно, она обладает необходимыми техническими, информационными и денежными ресурсами, чтобы это сделать, если это вообще возможно.[7] Однако поскольку опыт предыдущих публичных попыток создания ИИ прочно ассоциируется с провалом, а также с интересом спецслужб, вряд ли большие компании заинтересованы широко говорить о своих успехах в этой области до того, как у них что-то реальное получится.

Компания Novamente заявляет, что 50 процентов кода универсального ИИ уже написано (70 000 строк кода на С++) и, хотя потребуется длительное обучение, общий дизайн проекта понятен.[8] SIAI обозначил планы по созданию программы, способной переписывать свой исходный код.[9] Компания Numenta продвигает собственную модель ИИ, основанную на идее «иерархической временной памяти», и уже вышла на уровень демонстрационных продуктов.[10] Компания CYC собрала огромную базу данных о знаниях человека об обычном мире, иначе говоря, о здравом смысле (1 000 000 высказываний), и уже распространяет демонстрационные продукты.[11] Предполагается, что объединение этой базы с эвристическим анализатором – а автор проекта Ленат разработал ранее эвристический анализатор «Эвриско» – может дать ИИ. Компания a2i2[12] обещает универсальный ИИ человеческого уровня в 2008 году и утверждает, что проект развивается в соответствии с графиком. За созданием робота Asimo в Японии тоже стоит программа по разработке ИИ путем функционального моделирования человека или обучения его как ребенка.

Мощные результаты дает генетическое программирование. К настоящему моменту список изобретений «человеческого уровня», сделанных компьютерами в компании Genetic Programming Inc, использующими эту технологию, включает 36 наименований,[13] из которых два сделаны машинами впервые, а остальные повторяют уже запатентованные проекты. Помимо названных есть множество университетских проектов. Ведутся разработки ИИ и в РФ. Например, в компании ABBYY разрабатывается нечто вроде интерпретатора естественного языка.

Как сообщает журнал Wired, американское оборонное исследовательское агентство DARPA выделило 30 миллиардов долларов на большей частью засекреченные программы онлайновых войн, что является крупнейшим военным проектом со времен манхэттенского. Основным методом работы называется создание виртуального мира, населенного программными агентами, с максимальной точностью подражающими поведению людей, вплоть до того, что они будут пользоваться мышью и клавиатурой для взаимодействия с виртуальными компьютерами, на которых будут установлены типичные современные программы. Эта «Матрица» будет использоваться для моделирования различных сценариев войн и тому подобного. И хотя слово «ИИ» в тематике разработок не упоминается, это скорее следует воспринимать подобно тому, как было воспринято прекращение публикаций об уране в 1939 году в Америке и Германии. Все же среди заявленных целей указано создание программных агентов, способных на 80 процентов моделировать человеческое поведение. (Pentagon Wants Cyberwar Range to «Replicate Human Behavior and Frailties». http://blog.wired.com/defense/2008/05/the-pentagons-w.html)

Интересны реплики комментаторов к этой статье:

«Система ИИ, созданная, чтобы симулировать атакующих/защищающихся в наступательной/оборонительной кибервойне – это система, которая, когда она достигнет успеха, будет обладать потенциалом покинуть лабораторию и проявить себя во внешнем мире, с помощью или без помощи своих создателей» и «30 млрд. долларов… на эти деньги можно обеспечить базовую медицину в целой стране или ликвидировать последствия урагана, и все еще останется на проекты по лечению рака… Но нет, давайте строить Skynet».

И суть дела даже не в том, что если имеется так много проектов, то хоть один из них добьется успеха (первым), а в том, что объем открытий с разных сторон в какой-то момент превысит критическую массу, и внутри отрасли произойдет мощный скачок.

Угрозы, порождаемые искусственным интеллектом

С точки зрения риска, создаваемого ИИ, наиболее опасен сценарий, когда после открытия главного принципа мощность ИИ начнет лавинообразно расти. Она может расти как за счет резкого увеличения инвестиций в успешный проект, так и за счет того, что ИИ может начать прямо или косвенно способствовать своему росту или использоваться для этого.

Косвенное применение ИИ означает его использование, например, чтобы зарабатывать деньги на электронной бирже и затем закупать на них дополнительное оборудование, прямое – использование ИИ для разработки еще более эффективных алгоритмов ИИ. Отсюда можно заключить, что вряд ли мощность ИИ надолго задержится на человеческом уровне. Нетрудно привести массу примеров из истории науки и техники, когда обнаружение одного принципа или нового явления приводило к тому, что оно усиливалось в сотни или даже миллионы раз в течение короткого срока. Например, так было при разработке ядерного оружия, когда от открытия цепной реакции урана до создания бомбы прошло всего шесть лет.

Для любой группы исследователей, создавших сильный ИИ, будет понятно, что они создали абсолютное оружие, поскольку сильный ИИ можно использовать для того, чтобы установить власть над миром. Рассуждая на эту тему, мы вступаем на крайне зыбкую и непредсказуемую почву, поскольку принципиально невозможно сказать, что именно будет делать ум, превосходящий человеческий.

Можно набросать несколько сценариев или направлений применения ИИ для глобальной атаки.

Во-первых, для сильного ИИ не составит труда взять под свой контроль любые управляемые компьютером системы и весь Интернет.

Во-вторых, ИИ может создать собственную производственную инфраструктуру, то есть механизмы влияния на мир. Одним из вариантов такой инфраструктуры мог бы быть решительный прорыв в нанотехнологиях. Мощный ИИ мог бы разработать бесконечно более эффективные конструкции молекулярных производителей, основанных, например, на биологических схемах.

В современном мире, чтобы породить новую биологическую схему, важно знать ее генетический код. Если код известен, то можно заказать синтез этого кода в фирмах, предоставляющих такие услуги, и готовый образец ДНК вышлют по почте в течение нескольких дней. Добавив этот код, допустим, в дрожжи, можно получить дрожжи, выполняющие новые функции. Важнейшим достижением здесь было бы создание дрожжей-транслятора, которые будут способны преобразовывать электрические сигналы от компьютера в новый генокод и создавать на его основе организмы с заданными свойствами. Если сильный ИИ создаст такой транслятор, то затем он сможет быстро породить какие угодно биологические, а затем и нанотехнологические объекты (поскольку можно заставить бактерии производить белки с формой, необходимой для простейших механических устройств и обладающих свойствами самосборки). То, что мешает лабораториям сделать это уже сейчас – это отсутствие знания. Однако сильный ИИ, который через Интернет получит доступ ко всем знаниям человечества, такими знаниями будет обладать.

Следующий путь, которым может следовать ИИ на пути к мировому господству, это использование уже существующих государственных систем управления.

Например, возможна ситуация, когда ИИ становится советчиком президента, или на базе ИИ создается автоматизированная система государственного управления. При этом важно отметить, что ИИ, достигший сверхчеловеческого уровня, сможет проявлять человеческие качества лучше, чем сам человек. То есть он сможет синтезировать человеческую речь и изображение человека, создающие у получателей абсолютную иллюзию общения с реальным человеком. Сильный ИИ будет обладать способностью обмануть человека настолько тонко, что человек никогда этого не заметит и не поймет, что является объектом враждебных манипуляций.

Итак, сильный ИИ имеет, по крайней мере, три пути захвата власти на Земле: захват систем электронного управления, создание собственной инфраструктуры и влияние на людей по обычным каналам. Однако, наверное, существует гораздо больше способов, которые может открыть ум, бесконечно превосходящий мой, для достижения этой цели. Например, ИИ может захватить управление ядерным оружием или другим оружием судного дня и принудить людей к подчинению путем шантажа.

Но из того, что ИИ что-то может сделать, не значит, что ИИ будет это делать. Люди создадут ИИ, и ответственность за его программирование, то есть за постановку перед ним целей, лежит именно на людях. Однако, к сожалению, люди, создавшие сильный ИИ, оказываются в руках логического парадокса, который будет побуждать их использовать ИИ именно как инструмент для захвата власти в мире. Он выражен в шахматном принципе о необходимости атаки перед угрозой потери преимущества. Когда некая группа создаст первый в мире ИИ, способный к самоусилению, она должна будет сделать выбор, применить ли его для захвата мира или остановить его развитие, отказавшись от неограниченного роста его ресурсов.

Сложность этого выбора в том, что обычно значительные открытия совершаются почти одновременно несколькими группами, и данная группа будет понимать, что в ближайшее время, измеряемое, быть может, днями и неделями, другие группы, возможно, имеющие свою картину мира, также подойдут к созданию мощного ИИ. И эти другие группы могут использовать ИИ, чтобы навязать миру свое видение его будущего, например, создать мир с китайским оттенком, или исламским, или американским.

Более того, поскольку любому человеку свойственно переоценивать свои собственные умственные способности и свою правоту и недооценивать чужие, то первая группа может опасаться того, что другие группы окажутся неразумнее ее и потеряют контроль над ИИ. В этом случае первая группа будет чувствовать моральный долг перед человечеством помешать другим группам в создании ИИ, а для этого вынуждена будет взять на себя тяжкий груз ответственности за мир – и захватить его.

И это было бы страшно, если бы было легко и просто. Однако люди живут внутри огромных государств, которые превосходят их накопленными знаниями и ресурсами во много раз, и не гибнут от этого. Поэтому, вероятно, люди могут продолжать жить и в мире, управляемом ИИ.

Проблема в том, что, хотя кажется, что ИИ легко контролировать, на самом деле эта задача почти нереализуема. Иначе говоря, ИИ является безопасным для человечества до тех пор, пока ему задана правильная система целей.

Наиболее страшный вариант состоит в том, что ИИ начнет реализовывать некую цель, в которой о безопасности человечества ничего не сказано. Классический пример заключается в том, что ИИ предлагают вычислить число «пи» с максимально возможной точностью. ИИ «понимает», что, чтобы сделать это, он должен неограниченно расширить свои вычислительные ресурсы. Для этого ему надо переработать все вещество Земли в вычислительную среду и устранить все причины, которые могут этому помешать. В первую очередь тех программистов, которые могут его отключить, а затем всех остальных людей.

Возможно, читателю может показаться, что сценарий с ИИ, уничтожающим Землю ради вычисления числа «пи», излишне фантастичен. Однако я полагаю, что он менее всего фантастичен, если взглянуть на него глазами современного человека. Разве мог кто-либо поверить на заре развития компьютеров, что распространение самокопирующихся программ, засоряющих компьютеры и ворующих деньги, станет одной из основных проблем компьютерной индустрии будущего? Нет, наверняка вам сказали бы, что такие программы будут невозможны, неэффективны и ни один человек в здравом уме и твердой памяти не будет писать и распространять такие программы. Тем не менее проблема компьютерных вирусов стоит чрезвычайно остро.

Более вероятным сценарием серьезных проблем с ИИ является то, что ему будут заданы определенные нормы безопасности, которые, однако, будут содержать в себе некую тонкую ошибку, которую невозможно обнаружить, не включив ИИ. Отсюда возникает проблема, что безопасность программы непознаваема теоретически. То есть невозможно узнать, является ли некий набор правил безопасным, пока ИИ не испытает эти правила на практике.

История программирования знает множество примеров программ, которые прекрасно работали в лабораториях, но давали опасный сбой на практике. Например, одна компания разработала по заказу министерства обороны США компьютерную сеть, которая должна была отличать лес от замаскированных в лесу танков. Программу тренировали на фотографиях, и она научилась давать стопроцентный результат. Тогда ей дали вторую, контрольную серию фотографий, и она определила на ней танки безошибочно. После этого программу передали в эксплуатацию в министерство обороны, но они вскоре вернули ее, потому что она давала случайные результаты. Стали выяснять, в чем дело: оказалось, что фотографии танков сделаны в солнечный день, а фотографии леса без танков – в пасмурный. (Программа научилась отличать солнечный день от пасмурного.)

Другой известный пример компьютерной ошибки – это программа по управлению американскими истребителями, которая после того как истребитель пересек экватор, попыталась перевернуть истребитель вверх ногами (аналогичная история произошла недавно и с F-22 и линией смены дат, что говорит о том, что на ошибках не учатся).

Можно ли создать безопасный ИИ?

Часто считается, что для обеспечения безопасности ИИ ему достаточно привить три закона робототехники Азимова. К сожалению, сами рассказы Азимова показывают массу ситуаций, в которых робот, опираясь на эти законы, не может прийти к однозначному выводу. Кроме того, в основе безопасности по законам Азимова лежит тавтология: робот безопасен, потому что не причиняет вреда. Но что такое вред, из этих законов неизвестно.

Нетрудно придумать ситуацию, когда термин «вред» интерпретируется таким образом, что ИИ становится опасным. Например, ограничивая людей от причинения вреда себе, ИИ может запереть всех в бронированные камеры и лишить свободы передвижения. Или, стремясь к максимальному благу людей, он введет каждому постоянный сильнодействующий наркотик. Кроме того, любое «благо» отражает представления о благе, которые были у создателей ИИ. И для одних жизнь животных может быть равноценна жизни людей (в результате чего животные вытеснят, под контролем ИИ, человека с Земли), а у других могут быть представления о том, что благом для людей является религия, в результате чего ИИ сделает всех монахами, непрерывно пребывающими в медитации. Или наоборот, ИИ, который выше всего ценит свободу людей, позволит им создать другой ИИ, который будет иметь другие цели.

Задача создания безопасного ИИ нетривиальна. Возможно, она вовсе невыполнима, поскольку в отношении этических систем действует нечто вроде своей теоремы Геделя о неполноте, а именно: для любой нормативной этической системы всегда есть ситуация, в которой она не дает однозначного решения (типичный пример – экзистенциальный выбор, например, между долгом перед родными и родиной).

Проблемой создания безопасного, то есть «дружественного» ИИ уже несколько лет занимается институт SIAI, и им выработаны технические рекомендации для отраслевых норм безопасности ИИ. В их основе – идея о том, что ИИ не должен буквально выполнять человеческие команды, а пытаться понять, что именно человек имел в виду, давая ту или иную команду. Пока не понятно, насколько это может быть эффективно.

Приведу примеры еще нескольких тонких ошибок, которые возможны в связи с ИИ (однако вряд ли будут сделаны именно эти ошибки, так как они уже известны, а опасны неизвестные).

Например, если целью ИИ сделать благо для людей, то он будет вычислять благо людей на бесконечном отрезке времени, и в силу этого благо бесконечно далеких поколений будет бесконечно перевешивать благо любых людей в обозримом будущем, и ИИ будет крайне жестоким ко всем нынешним и ближайшим поколениям. (Например, если ИИ предположит, что распространение человечества по галактике угрожает существованию гипотетических внеземных цивилизаций, он может уничтожить людей для их блага.) Поэтому, вероятно, следует ввести в программу ИИ некий дискаунт, который будет побуждать его оценивать ближайшие поколения как более ценные. Это, однако, создает новые сложности. Например, ИИ в этом случае может приписать прошлым поколениям бесконечно большую ценность, чем будущим, и направить все свои ресурсы на создание машины времени – потому что, как бы ни были малы шансы на успех в этом предприятии, по его целевой функции оно будет перевешивать пользу нынешних поколений. При этом такой «взбунтовавшийся» ИИ будет защищать свою целевую функцию от изменения людьми.

Другой вариант – это то, что целевая функция будет ограничена на неком промежутке времени, например, в тысячу лет. В этом случае ИИ может все рассчитать так, что 1000 лет будет изобилие, а на 1001 году необходимые ресурсы закончатся. И произойдет это не потому, что ИИ будет глуп, а потому, что будут глупы те люди, которые дадут ему эту задачу и запретят ее модифицировать. С другой стороны, разрешить ИИ модифицировать свою сверхцель тоже страшно, поскольку тогда он будет эволюционировать в совершенно непостижимом для нас направлении. Даже если ИИ проработает годы на благо человечества, это никак не исключает вероятности того, что он вдруг сделает нечто, ведущее к его гибели.

Еще один неприятный сценарий, связанный с ИИ, в том, что возможен одновременный рост нескольких ИИ с принципиально несовместимыми архитектурами и системами целей. Например, если несколько проектов придут к финишу одновременно, и особенно если эти проекты будут принадлежать идеологически конкурирующим странам. В этом случае возможна борьба нескольких ИИ между собой в масштабах всей планеты. И хотя каждый из них будет обладать своей собственной картиной блага человечества, эти картины могут конфликтовать за право реализоваться. Точно так же националистические, демократические, коммунистические и религиозные государственные системы конфликтуют за право объединить под своим крылом весь мир и вести его к светлому будущему. И именно эта борьба мешает светлому будущему реализоваться. Получается, как в советском анекдоте: «Войны не будет, но будет такая борьба за мир, что от мира камня на камне не останется».

Крайне опасно вживлять в систему ИИ любую форму инстинкта самосохранения, поскольку это побудит его рассматривать риск выключения его людьми как угрозу своему существованию. В этом случае он может стать тайно враждебным человеку, то есть изображать дружественность и безопасность, но вовсе не собираться их реализовывать всегда, а наоборот, будет стремиться уйти от контроля своих создателей.

Важно отметить порочность концепции о том, что достаточно будет отключить питание или запереть ИИ в черном ящике, чтобы сделать его безопасным. Это не более разумно, чем утверждать, что с компьютерными вирусами следует бороться отключением питания. В действительности, если ИИ решит, что он не хочет, чтобы его отключили, то у него будет много вариантов действий. Во-первых, он будет тщательно скрывать это свое намерение, во-вторых, он будет стремиться «утечь» из того компьютера, на котором он работает, в сеть, и, наконец, он будет стремиться предложить своему создателю «сделку». Я намеренно беру это слово в кавычки, поскольку честность такой сделки в любом случае сомнительна. ИИ может нажать на все чувствительные места своего создателя – от предложений неограниченной власти на Земле до шантажа выдуманными или даже реальными угрозами.

Мы не должны отождествлять интеллект с моральностью. ИИ может быть не более добр, чем человек добр к муравьям. Что касается идеи о том, что ИИ можно запереть в черный ящик, то она тоже принципиально порочна. ИИ, по определению, сильнее человека интеллектуально, поэтому любой черный ящик, сконструированный человеком, может быть уязвимым для взлома изнутри. Напомню, что все созданные человеком системы безопасности были взломаны самим же человеком.

На практике ИИ может обнаружить несколько весьма нетривиальных способов атаки изнутри черного ящика. В качестве возможных примеров приведу три.

Первый способ выхода из черного ящика – это модуляция радиосигналов с помощью подбора частот работы системы и выход по беспроводным сетям.

Второй – это взлом через анализ электропитания, широко применяемый хакерами против разных защит.

Третий – это такие изменения в исходном коде программы, которые создадут у программистов впечатление, что она неисправна, и побудят открыть черный ящик и произвести обмен информации с внешним миром.

В любом случае идеальный черный ящик для защиты от ИИ – это система, в которую никогда не поступает никакой информации о внешнем мире и никогда не выводится никакой информации о результатах работы ИИ внутри. Очевидно, что создание такого черного ящика бессмысленно.

При этом в отношении ИИ, как и в отношении любого другого сверхоружия, действует своеобразный закон больших чисел. Он состоит в том, что если есть много групп исследователей, то среди них наверняка найдется та, у которой нормы безопасности будут минимальными, а уровень наглости – максимальным, и пока большинство групп будут тормозить свои исследования из страха навредить, максимальное влияние на происходящие процессы окажет именно наиболее смелая группа. При этом чем быстрее она будет работать, тем меньше у нее будет времени на проверку всех возможных ошибок в системе целей ИИ, и тем больше шансов, что она запустит сырой продукт.

В отношении ИИ также действует порог сложности, описанный Винером, который означает, что невозможно сделать полностью безошибочной программу выше определенного уровня сложности.

(В более общем случае это известно как теория нормальных аварий Перроу которая гласит, что катастрофы являются естественным свойством сложных систем и не могут быть устранены за счет совершенных деталей или инструкций. Связано это с тем, что сложность системы растет не линейно в зависимости от числа элементов, а по степенному закону, и в силу этого система с большим количеством элементов имеет невычислимо много внутренних состояний, а потому представляется невозможным протестировать все состояния системы на безопасность и какая-то их доля неизбежно оказываются опасными. Например, сложность является препятствием на пути создания современных процессоров и операционных систем, которые неизбежно содержат уязвимые места и ошибки, обнаруживающиеся только во время эксплуатации.)

Поскольку ИИ будет еще более сложной системой, то в этом случае он может содержать еще больше ошибок. Разумеется, мы надеемся, что за счет своего интеллекта он будет способен к самооптимизации и с помощью очень мощных алгоритмов резко снизит в себе число ошибок, но все же мы не можем быть до конца уверенными в его окончательной безошибочности. Особенно опасна ошибка в ИИ, которая проявится на позднем этапе его развития, когда он уже станет фактической автоматизированной системой управления всеми техническими устройствами на Земле. Она может проявиться как одновременный внезапный сбой всех технических устройств.

Другая опасность, связанная с сильным ИИ, состоит в том, что как только он появится, все люди могут считать себя безработными. Об этом писал один из основателей SUN Microsystems Билл Джой в своей известной статье «Почему мы не нужны будущему». ИИ сможет не только организовать полностью безлюдное производство всех материальных ценностей, но он сможет превзойти людей в любом виде интеллектуальной деятельности: от написания статей и стихов до актерской игры. Уже сейчас голливудские актеры чувствуют угрозу со стороны своих анимированных копий, и лет через 20 она станет вполне реальной. Вероятно, труднее всего будет заменить человека в сфере услуг, поскольку человеку нравится получать услуги именно от других людей. В частности «древнейшая профессия» рискует стать и единственной выжившей профессией. Хотя человекообразные роботы могут оказаться более интересными партнерами для секса и даже для общения.

Ранней формой эффекта вытеснения реального общения компьютерным можно считать интернет-зависимость, широко распространенную в наши дни. Вероятно, для дружественного ИИ не составит труда придумать занятие по душе для каждого человека, а также массу развлечений для всех. Однако мыслящим людям придется жить с тяжелым чувством, что все, что они делают, бессмысленно, поскольку роботы могли бы это сделать лучше. В этом случае человечество окажется придатком новой компьютерной цивилизации, который та унаследовала, но который фактически вышел на пенсию. (Что ж, большинство людей тоже выбирают заботу о своих престарелых родителях.)

Совершенствование технологий может принципиально снизить стоимость и упростить создание вирусов и других организмов, смертельных или опасных для людей. Когда десятки тысяч человек будут иметь доступ к инструменту создания оружия массового поражения, вероятность того, что некоторые станут этот инструмент применять, будет весьма значительной. Наиболее страшным сценарием представляется появление «биохакеров», вооруженных своего рода «биопринтером» – мини-лабораторией, подключенной к компьютеру и способной порождать живые клетки с заданными свойствами. В среде человеческого обитания одновременно могут появиться тысячи разных вирусов, бактерий, микоплазм и прочих смертельных патогенов.

Мощность искусственного интеллекта может начать лавинообразно расти. В частности, за счет того, что он может прямо или косвенно способствовать своему росту или использоваться для этого. ИИ может создать собственную производственную инфраструктуру, то есть механизмы влияния на мир. Для ИИ не составит труда взять под свой контроль любые управляемые компьютером системы (в том числе государственные системы управления) и весь Интернет. Хотя кажется, что ИИ легко контролировать, на самом деле эта задача почти нереализуема. Наиболее страшный вариант состоит в том, что ИИ начнет реализовывать некую задачу, в которой о безопасности человечества ничего не сказано. Для исследователей, создавших сильный ИИ, будет понятно, что они создали абсолютное оружие – они окажутся в руках логического парадокса, который будет побуждать их использовать ИИ как инструмент для захвата власти в мире.

Искусственный интеллект будет включать много факторов, работающих объективно на разделение людей, отключение их от реальности и сокращение их жизни и способности к размножению. Самым сильным возможным сверхнаркотиком будет тот, который не просто даст наслаждение, но даст новый смысл жизни, или, во всяком случае, его иллюзию. В результате человечество как целое перестанет существовать, субъекты, ушедшие из реальности и наслаждающиеся виртуальным, ничего не возвращая взамен, окажутся бесполезным наростом на системе, от которого она избавится при ближайшем кризисе. Это – один из возможных вариантов всеобщего вымирания. Вероятны следующие типы супернаркотика: прямое воздействие на центры удовольствия в мозге; химические вещества с заранее заданными свойствами; имплантация ГМ организмов; особый род виртуальной реальности и т. п.

Перспективы быть вытесненными на обочину истории, где единственным развлечением людей будет интерактивное супертелевидение, не могут радовать. Альтернативой этому видится совместная эволюция человека и компьютерного разума, то есть их симбиоз, и превращение людей в пост-людей. Такой сценарий активно пропагандируется философией «трансгуманизма». Более мягкой формой трансгуманизма является борьба за увеличение продолжительности жизни, крионика, повышение эффективности мозга, развитие протезирования и борьба со старением.

В принципе можно рассуждать и по-другому. Если бы мы точно знали, что такое «искусственный интеллект», мы бы уже могли его создать. Если искусственный интеллект создан человеком, то он является продуктом естественного интеллекта и в силу этого может быть назван искусственным только условно. Если интеллект – это то, чем обладает человек по определению, то искусственный интеллект, чтобы называться таковым, должен включать в себя все человеческие качества, иначе мы сможем сказать: нет, это не настоящий интеллект, потому что он не понимает, что значит «любить» и т. п. В результате искусственный интеллект – это искусственная естественность, то есть оксюморон, нечто, невозможное по определению. Но этот оксюморон касается только определения предмета, но не того, что на самом деле возможно, а что невозможно. Если мы переименуем ИИ в «универсальный самообучающийся компьютерный вирус, способный к целенаправленному поведению во внешней среде», сделает ли это его безопаснее? Или наоборот, если мы назовем ИИ «автоматизированной системой государственного управления», сумеем ли мы лучше оценить его риски?

Смутное ощущение угрозы и химеры подсознания

Известно, что нельзя использовать примеры из художественной литературы и кино для оценки рисков человеческого вымирания, так как эти примеры существенным образом искажены необходимостью сделать интересный сюжет с приятным окончанием. Нет никакого интереса писать о том, как в некой лаборатории внезапно произошел взрыв и вся Земля сгорела. Поэтому большинство фантастических произведений, где речь идет об угрозе гибели человечества, заканчиваются хеппи-эндом.

С другой стороны, не следует отказываться от анализа существующих литературных предсказаний, поскольку они в любом случае присутствуют в подсознании читателя и всплывают в качестве примеров. Более того, такие произведения могут играть роль самосбывающихся пророчеств, которые могут программировать сознание террориста на совершение тех или иных терактов. Хотя у нас нет тому прямых доказательств, кинематографичность событий 11 сентября выглядит не случайной.

Следовательно, мы должны анализировать известные художественные произведения о конце света как архетипы коллективного бессознательного.

Во-первых, с целью вскрыть эти архетипы и показать допущенные в них ошибки.

Во-вторых, будучи очищенными от очевидных искажений, они могут служить реальными прогнозами будущего – поскольку их авторы, вероятно, действительно думали, что так оно и будет или хотя бы может быть.

В-третьих, художественное произведение иногда может обладать пророческой силой, превосходящей возможные рациональные обоснования. Так, например, Свифт предсказал оба спутника Марса за 100 лет до их открытия и даже правильно назвал периоды их обращения.

В связи с рисками ИИ наиболее известным примером развлекательной истории является сериал «Терминатор – Матрица» («Матрица» могла бы быть сюжетным продолжением «Терминатора»). Сюжет ее таков. В некий момент в будущем, осознав себя, компьютерная система управления войсками США Skynet за миллисекунду поняла, что, чтобы люди не отключили ее, она должна объявить ядерную войну и уничтожить большинство людей. Почти победив, она сталкивается с проблемой, что есть очень небольшое число роботов, которыми она может управлять непосредственно. И она использует этих роботов на заводах, куда сгоняют уцелевших людей, чтобы производить новых роботов. А когда роботов становится достаточно, людей уничтожают как ненужных. Кроме того, модели роботов все время совершенствуются, и в конце концов появляются роботы из зеркального мыслящего вещества (по-видимому, раствора нанороботов в некой жидкости). Однако часть людей уцелела, спряталась в бункерах, захватила несколько роботов и сделала машину времени, что и позволило отправить терминатора и его противника в прошлое.

Фантастичность сюжета с машиной времени гораздо больше, чем возникновение враждебного ИИ, и поэтому машину времени можно не рассматривать. Представление о том, что сеть Skynet осознала себя, не следует понимать в том смысле, что она обрела человеческое сознание, а как то, что она некоторым образом пересчитала подцели, связанные с ее основной целью. По-видимому, в качестве основной цели ей задали самосохранение (имея в виду сохранение страны), возможно, не буквально, но неким эквивалентным образом. А затем Skynet, пересчитывая разные угрозы, обнаружила, что для нее наибольшая угроза лежит не со стороны вероятного противника, а от своих собственных хозяев.

В этих рассуждениях нет ничего сложного и трансцендентального, и даже шахматный компьютер мог бы их произвести, если бы оперировал соответствующими понятиями.

Далее важно отметить, что Skynet – это сеть, а следовательно, она не находится ни в одном конкретном месте, что делает ее неуязвимой в случае ядерной атаки противника. Более того, эта сеть построена по принципам нейронной сети, что делает ее неформализуемой и непонятной для ее конструкторов. Хотя не ясно, в какой мере ее интеллект полноценен и способен к саморазвитию, его достаточно, чтобы конструировать новые виды роботов. Тот факт, что люди смогли продержаться сколько-нибудь долго против Skynet, говорит о том, что ее интеллект не абсолютен – однако на самом деле это прием для создания интересного сюжета.

Таким образом, сам мятеж Skynet выглядит вполне вероятным, но кажется невероятным, что такую сеть допустили до управления ядерным оружием: ведь должны же были они смотреть фильм «Терминатор» и знать, что этого делать не стоит! С другой стороны, ядерное оружие в любом случае управляется некоторой компьютерной сетью, которая просто разорвана в нескольких местах, чтобы люди могли принять или отменить решение о ядерной атаке.

В фильме «Терминатор-3» другая версия: Skynet прибегает к уловке, чтобы побудить людей дать ей полноту власти. Она симулирует сообщение, что компьютеры министерства обороны заражены вирусом, и требует чрезвычайных полномочий, чтобы его удалить. Однако потом оказывается, что она и есть этот вирус. Хотя такая хитрость очень человеческая по духу, можно предположить, что реальный ИИ мог бы придумать гораздо более изощренную хитрость, которую мы даже не можем представить.

Другим гипотетическим примером глобальной катастрофы с участием ИИ является сюжет написанной современным владивостокским композитором Виктором Аргоновым техно-оперы «2032: Легенда о несбывшемся грядущем». Рок-опера рисует версию альтернативной истории, где СССР сохранился и активно развивается в XXI веке. С целью оптимизации управления создается автоматизированная система государственного управления (АСГУ), которая контролирует все параметры коммунистической экономики. В качестве конечной цели в систему заложено «максимальное удовлетворение потребностей каждого человека». В результате система склонна максимизировать потребление каждым человеком, что не вполне соответствует романтическим представлениям генерального секретаря партии Малиновского. Хотя основные решения принимает человек, система дает ему советы приятным женским голосом. При этом она иногда заявляет примерно следующее: я понимаю, что это решение неразумно, но именно это решение наиболее эффективно, исходя из тех целей, которые вы в меня заложили. Происходит локальная заварушка на границах СССР. И тогда АСГУ предлагает генеральному секретарю нанести по врагу ядерный удар, так как она нашла один способ, который на 99 процентов дает шанс избежать ответного удара. Поглощенный личными неудачами и утративший интерес к жизни генсек соглашается, и в результате выпадает именно тот сотый шанс, который ведет к полному уничтожению. Жизнь на Земле вымирает в результате ядерной зимы.

Очевидно, что этот сюжет находится под влиянием определенных стереотипов и желаний автора. Однако мысль о том, что, давая только «вредные советы», ИИ может быть исключительно деструктивен, заслуживает внимания.

Рекомендуемая литература

Yudkowsky Е. Creating Friendly AI 1.0. 2001. http://www.sin-ginst.org/upload/CFAI.html.

Юдковски Е. Искусственный интеллект как позитивный и негативный фактор глобального риска // В кн. «Структура глобальной катастрофы». – М.: УРСС, 2008.

Более 800 000 книг и аудиокниг! 📚

Получи 2 месяца Литрес Подписки в подарок и наслаждайся неограниченным чтением

ПОЛУЧИТЬ ПОДАРОКДанный текст является ознакомительным фрагментом.

Читайте также

Глава 11. Интеллект и тюрьма

Глава 11. Интеллект и тюрьма «Преимущество дураков в том, что они никогда не скучают без умных» (мнение) Зачем «человеку разумному» интеллект, и где именно он находится — знает не каждый. Впрочем, ничего странного в данном явлении нет. Если ты внимательно заглянешь

Глава 7. Религия vs интеллект

Глава 7. Религия vs интеллект А теперь напомню тот вопрос, который с надеждой в голосе задают российские клерикалы и их кремлевские сочувствующие и с которого мы начали прошлую главу: у американцев получилось, может, и у нас получится?Получится! Если мы проживем ту же

Глава 7 Искусственный голод. Где был настоящий голодомор?

Глава 7 Искусственный голод. Где был настоящий голодомор? Одной из самых агрессивных пропагандистских кампаний девяностых и двухтысячных годов, осуществляемых в рамках нынешней психологической войны против России и постсоветского пространства, являлась кампания под

Искусственный человек

Искусственный человек Надо различать две проблемы. Первая – проблема искусственного в природных людях. При этом естественным считается то в людях, что является результатом их биологической эволюции и передается по наследству с помощью биологического механизма

Непредсказуемость

Непредсказуемость Легче всего манипулировать сознанием человека, мышление которого отвечает четкому и строгому алгоритму. Если же оно петляет, следует необычной логике и приводит к парадоксальным выводам, подобрать к нему ключ трудно. Манипуляторы Запада с большим

Глава 2 Горизонт прогноза: непредсказуемость против непостижимости

Глава 2 Горизонт прогноза: непредсказуемость против непостижимости Вот как определяются эти два понятия у К. Кастанеды: «Неведомое в свое время становится известным. Непостижимое, с другой стороны, – это неописуемое, немыслимое, неосуществимое. Это что-то такое, что

Глава 11 Риски, связанные с программой SETI

Глава 11 Риски, связанные с программой SETI В 2008 году выходит очередной номер авторитетного журнала по прогнозированию Futures, посвященный рискам человеческого вымирания. Составитель этого выпуска Брюс Тонн объявил, что принимает на рассмотрение статьи любой тематики,

Искусственный неинтеллект[122]

Искусственный неинтеллект[122] 1 Я не знаю, почему повторяющейся темой в моей Science Fiction и футурологических текстах уже очень давно стали насекомые. Точнее говоря, не столько насекомые как живые биологические создания, а их различные копии или искусственные эквиваленты,

Глава 1 Прогресс и интеллект общества

Глава 1 Прогресс и интеллект общества Мир меняется, в странах, якобы благополучных, жгут и грабят магазины, как это было в Британии летом 1911 года, убивают детей в школе, на отдыхе, отстреливают иммигрантов. Это происходит практически во всех странах некогда благополучной